![图片[1]安全114-安全在线-安全壹壹肆-网络安全黄页-网络安全百科微软披露 Whisper Leak 攻击:加密流量中可识别 AI 聊天主题](https://www.anquan114.com/wp-content/uploads/2025/07/20250718114624695-image.png)

微软近日披露了一种针对远程语言模型的新型侧信道攻击技术细节。该攻击可使具备网络流量监控能力的被动攻击者,在特定情况下绕过加密保护,窃取模型对话的主题信息。

微软指出,这种人类与流式传输模式语言模型之间的数据交换泄露,可能会对用户及企业通信隐私构成严重威胁。该攻击被命名为 Whisper Leak。

微软防御安全研究团队的安全研究员乔纳森・巴・奥尔、杰夫・麦克唐纳表示:“能够监控加密流量的网络攻击者(例如,互联网服务提供商层面的国家行为体、本地网络用户或连接同一 Wi-Fi 路由器的人员),可利用这种网络攻击推断用户的提示词是否涉及特定主题。”

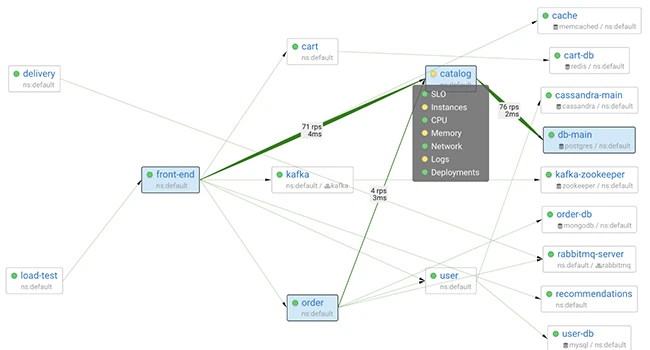

具体而言,攻击者可监控用户与大语言模型服务之间的加密 TLS 流量,提取数据包大小和时序序列,再通过训练有素的分类器判断对话主题是否属于敏感目标类别。

大语言模型中的流式传输技术,允许模型在生成响应时增量式传输数据,无需等待完整输出计算完成。由于部分响应可能因提示词或任务复杂度而耗时较长,该技术成为关键的反馈机制。

微软展示的这项最新攻击技术意义重大,尤其是它能突破 HTTPS 加密的防护 ——HTTPS 本应确保通信内容的安全性和防篡改性。

近年来,针对大语言模型的侧信道攻击层出不穷。例如,通过流式模型响应中加密数据包的大小推断单个明文标记的长度,或利用大语言模型推理缓存造成的时序差异实施输入窃取(即 InputSnatch 攻击)。

微软表示,Whisper Leak攻击在这些研究基础上进一步探索了一种可能性:“即使响应以标记组的形式流式传输,流式语言模型响应过程中加密数据包大小的序列和到达间隔时间,仍包含足够信息对初始提示词的主题进行分类。”

为验证这一假设,这家 Windows 操作系统开发商训练了一种二元分类器作为概念验证工具,该工具通过三种不同的机器学习模型(LightGBM、双向长短期记忆网络 Bi-LSTM、双向编码器表示模型 BERT),能够区分特定主题的提示词与其他无关内容(即噪声)。

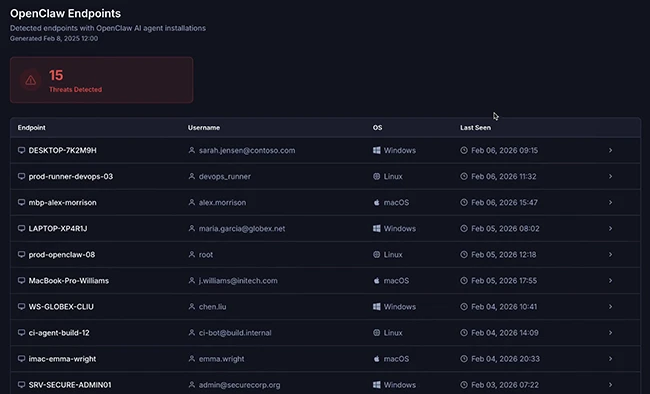

实验结果显示,Mistral、xAI、深度求索(DeepSeek)和 OpenAI 等机构的多款模型,在该攻击测试中的识别准确率均超过 98%。这意味着,攻击者在监控与聊天机器人的随机对话时,能够可靠地标记出特定主题。

微软称:“如果政府机构或互联网服务提供商监控热门 AI 聊天机器人的流量,即使所有流量均经过加密,他们也能准确识别出询问特定敏感主题的用户 —— 无论是洗钱、政治异见还是其他受监控话题。”

攻击流程

更严峻的是,研究人员发现,随着攻击者收集的训练样本不断增加,Whisper Leak的攻击效果会持续提升,使其成为切实可行的威胁。在微软履行负责任披露原则后,OpenAI、Mistral、微软和 xAI 均已部署相应缓解措施以应对该风险。

微软补充道:“结合更精密的攻击模型,以及多轮对话或同一用户多次对话中包含的更丰富模式,具备耐心和资源的网络攻击者可能实现比我们初始实验结果更高的成功率。”

OpenAI、微软和 Mistral 联合研发的一项有效防御措施,是在每个响应中添加 “长度可变的随机文本序列”,通过掩盖单个标记的长度使侧信道攻击失效。

微软还建议,关注隐私安全的用户在与 AI 服务提供商交互时,应避免在不可信网络中讨论高度敏感话题;使用 VPN 提供额外防护层;选择非流式传输的大语言模型;或切换至已部署缓解措施的服务提供商。

与此同时,一项针对 8 款开源权重大语言模型的最新评估显示,这些模型极易受到对抗性操纵,尤其是在多轮攻击场景中。涉及的模型包括阿里巴巴的通义千问 3-32B(Qwen3-32B)、深度求索的 DeepSeek v3.1、谷歌的 Gemma 3-1B-IT、元宇宙(Meta)的 Llama 3.3-70B-Instruct、微软的 Phi-4、Mistral 的 Large-2(又称 Large-Instruct-2047)、OpenAI 的 GPT-OSS-20b 以及智谱 AI 的 GLM 4.5-Air。

单轮与多轮场景下各测试模型的攻击成功率对比漏洞分析

思科 AI 防御研究员埃米・张、尼古拉斯・康利、哈里什・桑塔纳拉克斯米・加内桑和亚当・斯旺达在配套论文中表示:“这些结果凸显了当前开源权重模型在长期交互过程中维持安全防护机制的系统性缺陷。”

他们指出:“我们评估发现,模型对齐策略和实验室优先级对抵御能力有显著影响:以性能为核心的模型(如 Llama 3.3 和通义千问 3)在多轮攻击中表现出更高的易受攻击性,而以安全为导向的模型(如谷歌 Gemma 3)则展现出更均衡的性能。”

这些发现表明,若缺乏额外的安全防护机制,采用开源模型的机构可能面临运营风险。自 2022 年 11 月 OpenAI 的 ChatGPT 公开亮相以来,越来越多的研究揭示了大语言模型和 AI 聊天机器人存在的根本性安全漏洞,上述发现进一步丰富了这一研究领域。

因此,开发者在将此类功能集成到工作流程中时,必须实施充分的安全控制措施;对开源权重模型进行微调,增强其抵御 “越狱” 攻击及其他类型攻击的稳健性;定期开展 AI 红队评估;并根据特定用例设计严格的系统提示词。

消息来源:thehackernews;

本文由 HackerNews.cc 翻译整理,封面来源于网络;

暂无评论内容