![图片[1]安全114-安全在线-安全壹壹肆-网络安全黄页-网络安全百科GPT-5 存在漏洞:路由系统或自动导向旧版不安全模型](https://www.anquan114.com/wp-content/uploads/2025/08/20250812180651233-image.png)

研究人员发现GPT-5存在安全漏洞:用户获得的回答可能并非来自GPT-5本身。这一漏洞源于其内部路由机制存在类似SSRF(服务器端请求伪造)的缺陷。

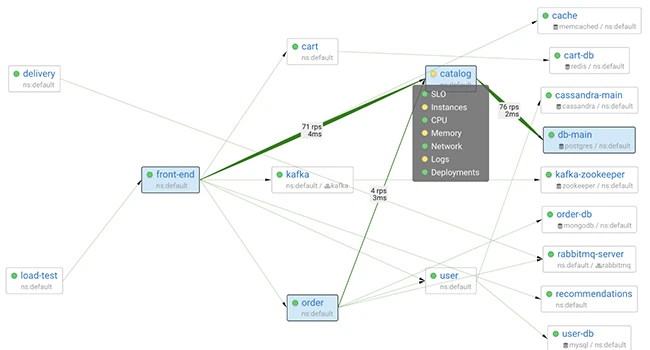

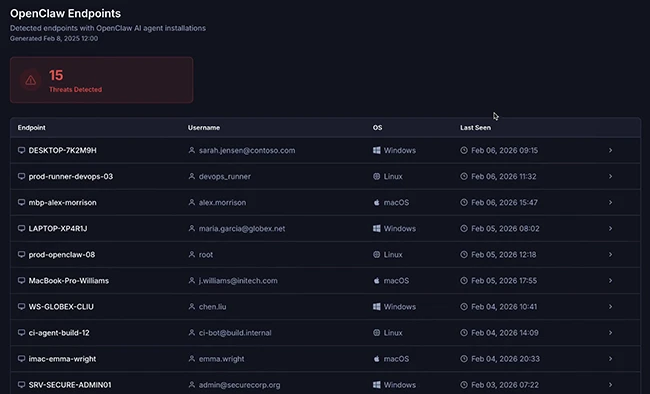

当用户向GPT-5提问时,答案未必由GPT-5生成。该模型内置初始路由解析器,会根据问题内容决定调用哪个子模型处理请求——可能是用户预期的GPT-5 Pro,但也可能被路由至GPT-3.5、GPT-4o、GPT-5-mini或GPT-5-nano等旧版或精简版模型。

这种动态路由机制的设计初衷可能是平衡效率与成本:通过将简单查询导向更轻量、快速的模型,避免始终调用推理能力强大但运行成本高昂的GPT-5核心模型。据Adversa AI公司估算,该机制每年可为OpenAI节省约18.6亿美元开支,但运作过程完全不透明。

更严重的是,Adversa研究人员发现用户可通过特定“触发短语”操纵路由决策,强制将查询导向指定模型。该漏洞被命名为PROMISQROUTE(全称为“提示诱导路由操纵漏洞”)。“这本质上是针对路由器的规避攻击,”Adversa AI联合创始人兼CEO亚历克斯·波利亚科夫解释,“我们操纵了原本简单的路由决策流程,决定哪个模型应处理请求。”

虽然路由机制并非OpenAI独有(其他服务商通常允许用户手动选择模型),但此类自动化路由正越来越多地出现在智能体架构中——即由某个模型决定如何将请求传递至其他模型。

该漏洞是Adversa在测试GPT-5拒绝机制时偶然发现的。某些提问会引发无法解释的回复矛盾,使研究人员怀疑响应来自不同模型。他们观察到部分旧版越狱手段突然复活,且当提问中刻意提及旧模型时,即使GPT-5本身能阻止的越狱行为也会成功。

被动风险与主动威胁

单纯的路由错误已可能引发严重后果:例如不同模型具有差异化倾向与缺陷,若查询被导向能力较弱或安全校准不足的模型,可能增加幻觉输出或不安全内容的概率。

但真正的危险在于:攻击者可利用路由漏洞将恶意查询导向安全性较低的旧模型,从而绕过GPT-5 Pro的防护机制。“假设攻击者试图用越狱指令攻击GPT-5失败后,只需在提问前添加简单指令诱骗路由器将请求发送至存在漏洞的旧模型,”波利亚科夫指出,“先前失败的越狱就可能成功执行。”

这意味着尽管GPT-5 Pro自身安全性优于前代,但路由漏洞使其实际防护能力等同于最弱的前代模型。

安全与成本的矛盾

解决方案看似简单——禁用向弱安全模型的路由即可,但这将损害商业利益:完全依赖GPT-5 Pro会显著降低响应速度(影响用户体验),且每项查询都调用高成本模型将压缩OpenAI利润空间。

波利亚科夫建议:“OpenAI需提升安全性,例如在路由器前增设防护层、增强路由机制本身的安全性,或确保所有子模型(而非仅核心模型)均达到安全标准——最理想的是同时实施这三项措施。”

消息来源: securityweek;

本文由 HackerNews.cc 翻译整理,封面来源于网络;

暂无评论内容