![图片[1]安全114-安全在线-安全壹壹肆-网络安全黄页-网络安全百科研究人员发现严重 AI 漏洞,Meta、英伟达和微软推理框架受影响](https://www.anquan114.com/wp-content/uploads/2024/11/20241105095854656-image.png)

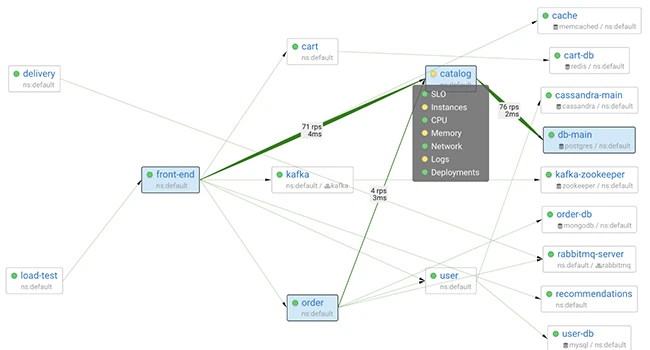

网络安全研究人员近日披露一系列影响人工智能推理引擎的关键漏洞,波及Meta、英伟达、微软及vLLM、SGLang等开源项目。这些被统称为”ShadowMQ”的安全隐患,均源于ZeroMQ与Python pickle反序列化的不安全使用模式。

漏洞根源可追溯至Meta Llama大型语言模型框架中的一个缺陷(CVE-2024-50050)。该框架通过ZeroMQ套接字在网络暴露,并利用recv_pyobj()方法对传入数据执行pickle反序列化,使得攻击者可通过发送恶意数据实现任意代码执行。

研究机构Oligo发现,相同的不安全模式已在多个推理框架中重现:英伟达TensorRT-LLM(CVE-2025-23254,已修复)、微软Sarathi-Serve(未修复)、Modular Max Server(已修复)、vLLM(CVE-2025-30165,默认引擎切换)及SGLang(不完全修复)。调查显示,这些漏洞多源于直接复制粘贴代码行为——例如SGLang承认适配vLLM代码,而Modular Max Server则同时借鉴了这两个项目的逻辑。

作为AI基础设施的核心组件,推理引擎一旦被攻陷,攻击者可在集群中执行任意代码、提升权限、窃取模型,甚至部署加密货币挖矿程序等恶意负载。研究人员指出:”项目开发速度惊人,借鉴架构组件已成常态,但当代码复用包含不安全模式时,后果将快速扩散。”

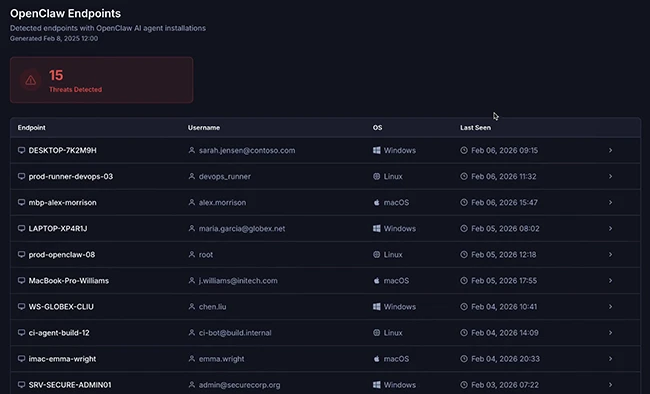

同期另一报告显示,AI代码编辑器Cursor的内置浏览器同样存在风险,可通过JavaScript注入技术窃取凭证,恶意扩展程序更可能使开发者工作站完全失控。

消息来源:thehackernews;

本文由 HackerNews.cc 翻译整理,封面来源于网络;

暂无评论内容