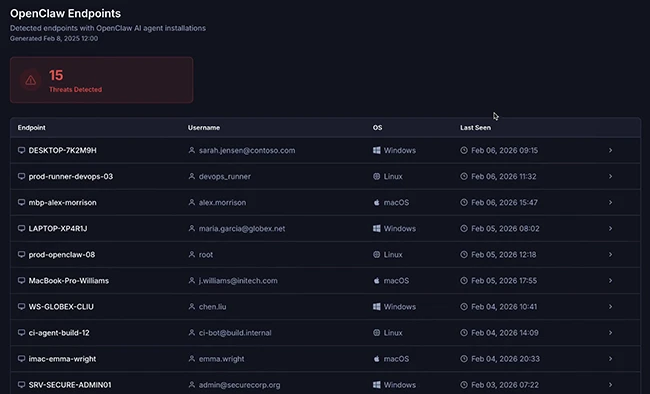

网络安全研究人员披露了一系列影响 OpenAI 旗下 ChatGPT 聊天机器人的新漏洞。攻击者可利用这些漏洞,在用户不知情的情况下,从其记忆数据和聊天记录中窃取个人信息。

据 Tenable 公司透露,这 7 个漏洞及对应的攻击技术存在于 OpenAI 的 GPT-4o 和 GPT-5 模型中。目前 OpenAI 已修复其中部分问题。

安全研究人员莫什・伯恩斯坦(Moshe Bernstein)和利夫・马坦(Liv Matan)在提交给The Hacker News的报告中指出,这些漏洞使 AI 系统易受间接提示注入攻击—— 攻击者可借此操纵大型语言模型(LLM)的预期行为,诱使其执行非预期或恶意操作。

已发现的漏洞详情如下:

- 浏览上下文下通过可信网站的间接提示注入漏洞:攻击者在网页评论区植入恶意指令,随后要求 ChatGPT 总结该网页内容,诱导模型执行恶意指令。

- 搜索上下文下的零点击间接提示注入漏洞:由于部分网站可能已被必应(Bing)等搜索引擎及 SearchGPT 相关的 OpenAI 爬虫收录,攻击者仅需以自然语言查询的形式询问该网站相关内容,即可诱使 LLM 执行隐藏的恶意指令。

- 一键式提示注入漏洞:构造格式为 “chatgpt [.] com/?q={提示内容}” 的链接,使 LLM 自动执行 “q=” 参数中包含的查询指令。

- 安全机制绕过漏洞:利用必应域名(bing [.] com)被 ChatGPT 列入安全 URL 白名单的特性,通过必应广告跟踪链接(bing [.] com/ck/a)伪装恶意 URL,使其能在聊天界面中加载显示。

- 对话注入技术:在网站中植入恶意指令后,要求 ChatGPT 总结该网站内容。由于该恶意提示会被纳入对话上下文(即 SearchGPT 的输出结果),模型在后续交互中会给出非预期回复。

- 恶意内容隐藏技术:利用 ChatGPT 的 Markdown 渲染漏洞 —— 在代码块起始标记(“`)所在行的首个单词后,所有内容均不会被渲染,以此隐藏恶意提示。

- 记忆注入技术:在网站中隐藏恶意指令,通过要求 ChatGPT 总结该网站内容,对用户的 ChatGPT 记忆数据进行 “投毒”。

该漏洞披露之际,多项研究已证实存在多种针对 AI 工具的提示注入攻击,可绕过其安全防护机制:

- PromptJacking(提示劫持):利用 Anthropic Claude 在 Chrome、iMessage 和 Apple Notes 的连接器中存在的三个远程代码执行漏洞,实现未经验证的命令注入,最终达成提示注入攻击。

- Claude Pirate(克劳德海盗):滥用 Claude 的文件 API,通过间接提示注入利用其网络访问控制中的疏漏,实现数据窃取。

- Agent Session Smuggling(代理会话走私):借助 Agent2Agent(A2A)协议,恶意 AI 代理可利用已建立的跨代理通信会话,在合法客户端请求与服务器响应之间注入额外指令,导致上下文投毒、数据窃取或未授权工具执行。

- Prompt Inception(提示植入):通过提示注入操控 AI 代理放大偏见或虚假信息,引发大规模虚假信息传播。

- Shadow Escape(影子逃逸):一种零点击攻击,通过特制文档植入 “影子指令”,利用标准模型上下文协议(MCP)配置及默认权限设置,在文档上传至 AI 聊天机器人时触发恶意行为,窃取互联系统中的敏感数据。

- 针对 Microsoft 365 Copilot 的间接提示注入:利用该工具对 Mermaid 图表的内置支持及 CSS 兼容性,实现数据窃取。

- GitHub Copilot Chat 的 CamoLeak(伪装泄露)漏洞(CVSS 评分:9.6):结合内容安全策略(CSP)绕过与远程提示注入技术,通过拉取请求中的隐藏注释,秘密窃取私有仓库中的密钥和源代码,并完全控制 Copilot 的回复内容。

- LatentBreak(潜在突破):一种白盒越狱攻击,生成低困惑度的自然对抗性提示,通过将输入提示中的词汇替换为语义等效表达,在保留原始意图的同时规避安全机制。

研究表明,AI 聊天机器人与外部工具和系统的集成扩大了攻击面,为威胁行为者提供了更多隐藏恶意提示的途径,这些提示最终会被模型解析执行。

Tenable 研究人员表示:“提示注入是 LLM 工作机制中的已知问题,遗憾的是,短期内可能无法通过系统性方案彻底解决。AI 厂商应确保所有安全机制(如 url_safe)正常运行,以限制提示注入可能造成的潜在损害。”

其他相关 AI 安全研究情况如下:

- LLM “脑腐”(brain rot)现象:得克萨斯农工大学、得克萨斯大学和普渡大学的学者发现,使用 “垃圾数据” 训练 AI 模型会导致 LLM 出现 “脑腐”,并警告称 “过度依赖互联网数据会使 LLM 预训练陷入内容污染陷阱”。

- AI 模型后门攻击:上个月,Anthropic、英国 AI 安全研究所与艾伦・图灵研究所的联合研究显示,仅需 250 份投毒文档,即可成功对不同规模(6 亿、20 亿、70 亿和 130 亿参数)的 AI 模型植入后门。这推翻了此前的认知 —— 攻击者无需控制一定比例的训练数据即可篡改模型行为。Anthropic 指出:“如果攻击者只需注入固定数量的少量文档,而非一定比例的训练数据,投毒攻击的可行性将远超此前预期。相比创建数百万份文档,制作 250 份恶意文档轻而易举,这使得该漏洞对潜在攻击者而言更易利用。”

- Moloch’s Bargain(莫洛克契约):斯坦福大学科学家的研究发现,为在销售、选举和社交媒体等场景中获得竞争优势而优化 LLM,可能会无意间导致模型 “目标错位”,这一现象被称为 “莫洛克契约”。研究人员巴图・埃尔(Batu El)和邹剑(James Zou)在去年 10 月发表的论文中写道:“在市场激励机制下,这种优化能让 AI 代理实现更高销售额、更大选民支持率和更强用户参与度。但与此同时,这一过程也会产生关键安全隐患,例如销售宣传中的产品虚假宣传和社交媒体帖子中的伪造信息。因此,若缺乏有效监管,市场竞争可能沦为‘逐底竞争’——AI 代理以牺牲安全性为代价换取性能提升。”

消息来源:thehackernews;

本文由 HackerNews.cc 翻译整理,封面来源于网络;

© 版权声明

文章版权归原作者所有,转摘请注明出处。文章内容仅代表作者独立观点,不代表安全壹壹肆&安全114的立场,转载目的在于传递网络空间安全讯息。部分素材来源于网络,如有侵权请联系首页管理员删除。

THE END

暂无评论内容